Agentic AI-Plattform: Datenschutzkonforme KI

Die Agentic AI Platform bietet eine souveräne, datenschutzfreundliche KI-Architektur, die auf den Prinzipien des Confidential Computing basiert. Durch die Nutzung von Trusted Execution Environments (TEEs) für CPU und GPU – darunter Intel TDX, AMD SEV-SNP und NVIDIA Confidential Computing – gewährleistet das System, dass alle Daten und KI-Workloads während der gesamten Verarbeitung verschlüsselt und isoliert bleiben. Jede Komponente, von vertraulichen virtuellen Maschinen bis hin zu GPU-beschleunigter Inferenz, arbeitet in zertifizierten, hardwaregeschützten Umgebungen, wodurch die Abhängigkeit vom Vertrauen in den Anbieter entfällt. Dank föderierter Identität, clientseitig verwalteter Verschlüsselungsschlüssel und durchgängig verschlüsselter Datenflüsse schafft die Agentic AI Platform eine nachweisbare technische Sicherheit über den gesamten KI-Lebenszyklus hinweg. Diese Architektur ermöglicht es Unternehmen, fortschrittliche KI-Dienste mit vollständiger Datensouveränität, Vertraulichkeit und Compliance von Grund auf bereitzustellen und zu skalieren.

1. Einleitung

Die Agentic-KI-Plattform ist eine zukunftsweisende, datenschutzfreundliche KI-Plattform, die speziell für den Einsatz in souveränen Systemen entwickelt wurde. Sie vereint vertrauliches Rechnen, föderierte Authentifizierung und verschlüsselte Datenorchestrierung in einem durchgängigen Vertrauensrahmen. Kernstück des Systems ist die technische Gewährleistung – ein verifizierbarer, hardwarebasierter Schutz der Daten während der Nutzung, Übertragung und Speicherung – wodurch das Vertrauen in den Infrastrukturbetreiber entfällt.

Anders als herkömmliche Cloud-Modelle, die auf prozedurale Kontrollen oder anbieterseitig verwaltete Verschlüsselung setzen, integriert die Agentic AI Platform Sicherheit direkt in die Hardware. Trusted Execution Environments (TEEs) für CPU und GPU – darunter Intel TDX, AMD SEV-SNP, IBM Secure Execution und NVIDIA Confidential Computing – schaffen hardwarebasierte Isolationsgrenzen, in denen Code und Daten kryptografisch geschützt bleiben, selbst vor dem Hypervisor oder Cloud-Administrator. Diese Grundlagen erstrecken sich über vertrauliche Container, föderiertes Single Sign-On und Schlüsselverwaltungssysteme, die die vollständige Kontrolle des Kunden über kryptografisches Material gewährleisten.

Das Ergebnis ist eine nachweislich souveräne KI-Umgebung, die die vertrauliche Datenverarbeitung, Modellausführung und den Informationsabruf über hybride oder mandantenfähige Infrastrukturen hinweg ermöglicht – und gleichzeitig sicherstellt, dass niemals Klartextdaten, Anmeldeinformationen oder Modellartefakte außerhalb bestätigter, verschlüsselter Grenzen offengelegt werden.

2. Designphilosophie: Technische Qualitätssicherung

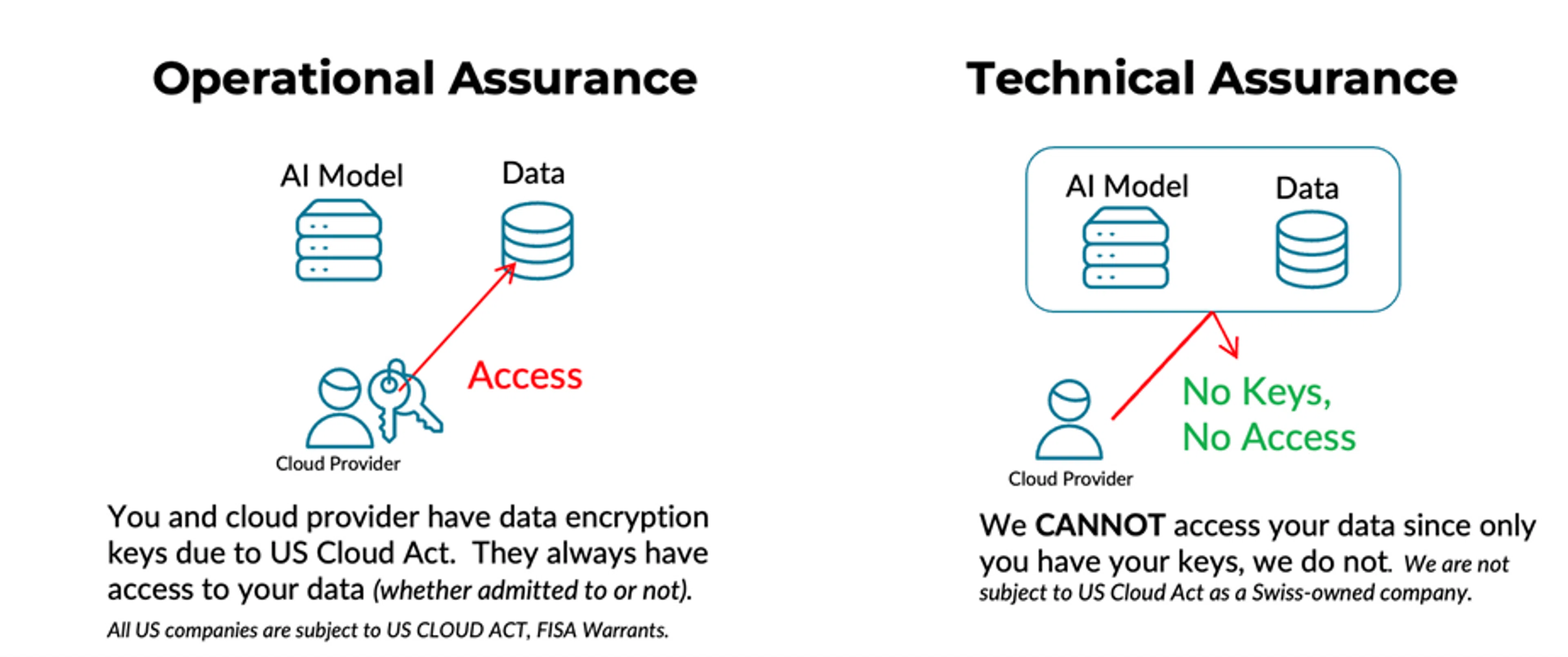

Viele Cloud-Anbieter setzen zum Schutz von Kundendaten primär auf operative Sicherheitsmaßnahmen – also Richtlinien, Prozesse und administrative Kontrollen. Diese Maßnahmen sind zwar notwendig, basieren aber zwangsläufig auf dem Vertrauen in die Integrität und Compliance des Anbieters. In diesem Modell kontrolliert der Anbieter letztendlich die Infrastruktur und behält häufig den Zugriff auf die Verschlüsselungsschlüssel. Dadurch bleibt ein Restrisiko bestehen, dass auf Daten zugegriffen werden könnte – sei es durch interne Berechtigungen, Fehlkonfigurationen oder aufgrund rechtlicher Verpflichtungen gemäß Rahmenwerken wie dem US-amerikanischen CLOUD Act (siehe Abbildung 1).

Die Architektur der Agentic AI Platform verfolgt einen grundlegend anderen Ansatz und basiert auf technischer Sicherheit statt auf vertrauensbasierten Betriebskontrollen. Als schweizerisches Unternehmen ist sie auf clientseitig kontrollierter Verschlüsselung, vertraulichem Rechnen und hardwareseitiger Isolation aufgebaut. Diese kryptografischen und siliziumbasierten Schutzmechanismen machen es selbst dem Infrastrukturanbieter technisch unmöglich, auf Klartextdaten zuzugreifen. Kunden behalten die alleinige Kontrolle über ihre Verschlüsselungsschlüssel, während alle Berechnungen und Datenübertragungen in geprüften, verschlüsselten Umgebungen stattfinden.

Abbildung 1: Operative vs. technische Qualitätssicherung

Diese Philosophie basiert auf dem Schutz von Daten über ihren gesamten Lebenszyklus hinweg – bei der Übertragung, im Ruhezustand und bei der Nutzung – und gewährleistet, dass sensible Workloads, KI-Modelle und Kundendaten von Grund auf vertraulich und souverän bleiben. Die folgende Architektur veranschaulicht die Umsetzung dieses Prinzips im gesamten Stack: von verschlüsselter Speicherung und Retrieval-Augmented Generation (RAG) bis hin zu GPU-basierter KI-Verarbeitung und clientseitiger Orchestrierung, allesamt gesichert durch Confidential Computing und verifizierte Vertrauensgrenzen.

3. Phoenix Technologies Architektur für technische Qualitätssicherung

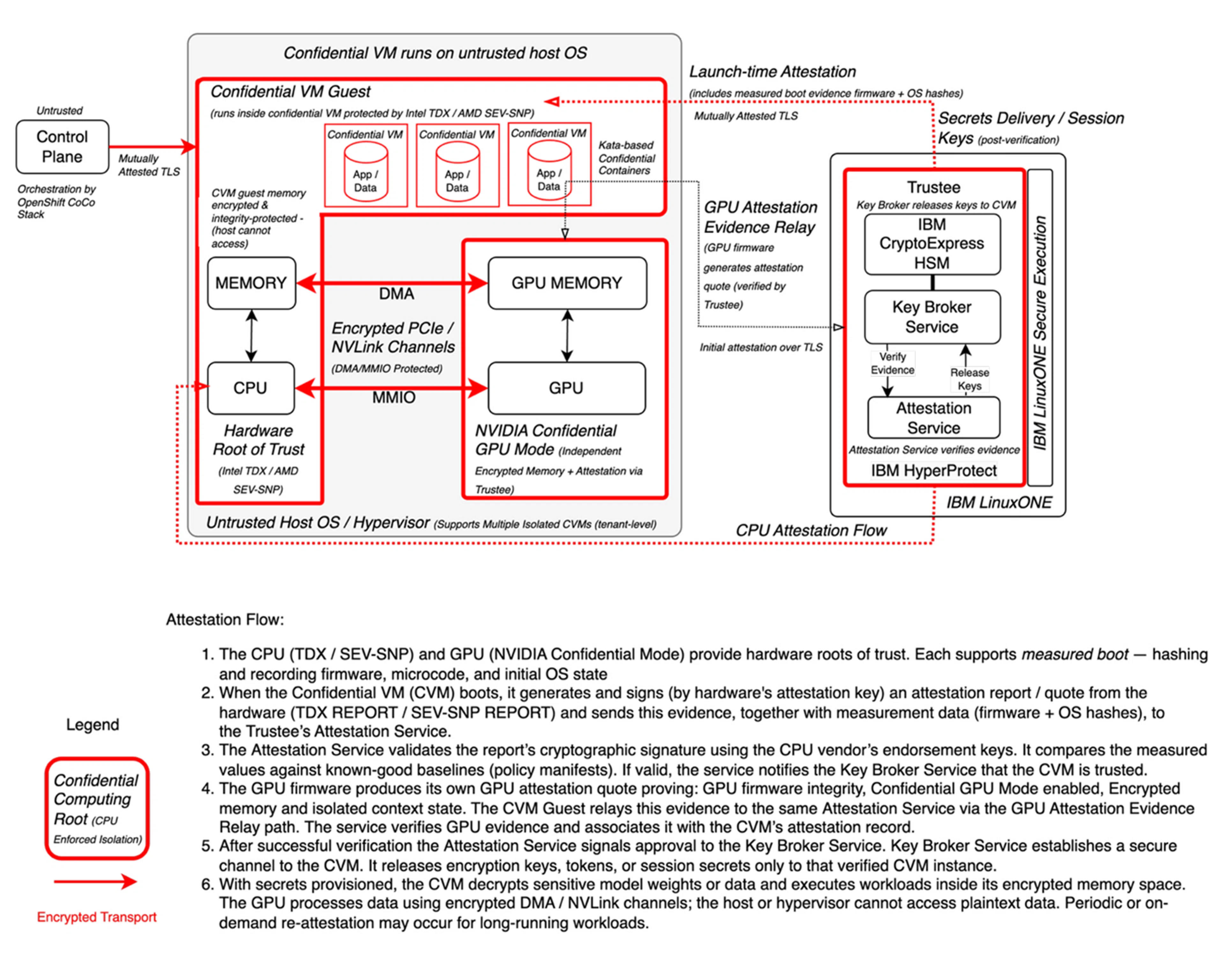

Grundlage dieser Architektur in Abbildung 2 ist vertrauliches Rechnen, ermöglicht durch vertrauenswürdige Ausführungsumgebungen (Trusted Execution Environments, TEEs) für CPU und GPU, die Phoenix Technologies in Zusammenarbeit mit IBM Research und Red Hat entwickelt. Innerhalb der CPU-Domäne werden Workloads in sicheren, vertraulichen virtuellen Maschinen ausgeführt, wie sie beispielsweise von Intel TDX oder AMD SEV bereitgestellt werden. Hier sind sowohl Code als auch Daten kryptografisch vom Host-Betriebssystem und Hypervisor isoliert. Der Speichercontroller (MemCtrl) verschlüsselt und entschlüsselt alle Daten während des Datenaustauschs zwischen CPU und DRAM. Dadurch wird sichergestellt, dass ein Angreifer, selbst wenn er physischen Zugriff auf den Speicher erlangt, nur den verschlüsselten Text einsehen kann. Diese Schutzebene gewährleistet, dass Berechnungen mit sensiblen Daten vertraulich und manipulationssicher bleiben.

Abbildung 2: Vertrauliche Rechnerarchitektur von Phoenix Technologies AG

3.1. Vertrauenswürdige GPU-Attestierung mit Confidential Computing

Ergänzend dazu richtet der NVIDIA Confidential Computing-Modus (z. B. H100) eine GPU-TEE mit verschlüsseltem GPU-Speicher und zertifizierter Firmware ein. Die GPU erzeugt eigene Zertifizierungsnachweise, die die CVM zur Überprüfung an den Trustee weiterleitet. Die Zertifizierung stellt sicher, dass sowohl GPU als auch CPU in vertrauenswürdigen, sicheren Umgebungen arbeiten, bevor die sichere Berechnung beginnt.

Im aktivierten Modus für vertrauliches Rechnen werden alle Daten im GPU-Speicher verschlüsselt und die Kommunikation zwischen CPU und GPU im Rahmen eines vollständig verschlüsselten und zertifizierten Rechenpfads gesichert. GPUs sind direkt in die vertrauenswürdige Ausführungsumgebung eingebunden und führen Modellinferenz, Embedding-Generierung und andere KI-Workloads vollständig im verschlüsselten GPU-Speicher aus. Der hardwarebasierte Speicherschutz gewährleistet, dass Modellgewichte, Zwischenergebnisse und Benutzerdaten vor externem Zugriff geschützt bleiben. Die initiale CVM-Zertifizierung wird über TLS an den Trustee gesendet. Nach erfolgreicher Verifizierung stellt der Trustee/Key Broker kurzlebige Anmeldeinformationen aus. Für den nachfolgenden Austausch von Schlüsseln und den Zugriff auf die Steuerungsebene wird mTLS verwendet. Zusammen bilden diese Elemente eine durchgängige, vertrauliche KI-Verarbeitungspipeline.

Kern der Vertrauensarchitektur ist der Trustee, der für die Attestierungsprüfung, die Schlüsselvermittlung und kryptografische Operationen zuständig ist. Anders als bei Hyperscaler-Implementierungen, wo Attestierungs- und Schlüsselverwaltungsdienste typischerweise in standardmäßigen, vom Anbieter kontrollierten VMs ausgeführt werden, implementiert die Phoenix-Architektur den Trustee innerhalb von IBM LinuxONE Secure Execution (SE)-Umgebungen. Dadurch entsteht eine verifizierbare Vertrauensbasis, die sich über Hardware- und Softwaregrenzen hinweg erstreckt.

IBM LinuxONE Secure Execution bietet eine vertrauliche Rechenumgebung der Mainframe-Klasse, die virtuelle Maschinen vollständig vom Host-Betriebssystem, Hypervisor und Management-Stack isoliert. Die zugrundeliegende IBM Z-Hardware etabliert eine präzise geprüfte Boot-Kette und stellt so sicher, dass Hypervisor, Firmware und alle Systemkomponenten kryptografisch validiert werden, bevor eine Arbeitslast gestartet wird. Dadurch wird jegliche Form von Introspektion oder Manipulation der Trustee-Umgebung auf Host-Ebene verhindert.

IBM Hyper Protect Virtual Server (HPVS) hosten die Schlüsselverwaltungs- und Attestierungsdienste des Trustees. HPVS gewährleistet strikte Isolationsgrenzen, sodass sowohl das Gastbetriebssystem als auch der Anwendungsspeicher jederzeit geschützt sind. Der Betriebszustand und der Speicher des Trustees sind somit kryptografisch gesichert und überprüfbar, wodurch die Vertraulichkeit und Integrität aller Attestierungs- und Schlüsselverwaltungsvorgänge garantiert wird.

Die kryptografischen Operationen des Trustees basieren auf IBM CryptoExpress HSMs, FIPS 140-2 Level 4-zertifizierten Hardwaremodulen, die für manipulationssichere Schlüsselspeicherung und hardwarebasierte kryptografische Verarbeitung entwickelt wurden. Schlüssel werden vollständig innerhalb der HSM-Grenzen generiert, gespeichert und verwendet, sodass sie niemals in Software oder im Arbeitsspeicher offengelegt werden. Die HSMs unterstützen sichere Schlüsselexportrichtlinien gemäß dem „Keep Your Own Key“-Modell (KYOK) und entsprechen damit dem Plattformprinzip der clientseitig kontrollierten Verschlüsselung.

IBM LinuxONE Secure Boot und seine durchgängige Vertrauenskette erstrecken sich von der Firmware über den Hypervisor bis hin zu den Gastsystemen und erzeugen so verifizierbare Messdaten. Beim Start wird dieser Nachweis in die Attestierung des Trustees aufgenommen, wodurch unabhängig bestätigt werden kann, dass der Trustee selbst auf einer unverfälschten, kryptografisch verifizierten Infrastruktur läuft. Dies gewährleistet, dass die Attestierungs- und Schlüsselverwaltungsdienste von Phoenix selbst vertrauliche Rechenlasten darstellen – ein grundlegender architektonischer Unterschied zu Hyperscalern, deren Attestierungs- und Schlüsselbrokerdienste typischerweise in nicht vertrauenswürdigen, vom Anbieter verwalteten Domänen operieren.

3.2. Neue Technologien für verschlüsselte Verbindungen auf Chipebene

Ein wesentlicher Fortschritt dieses Designs ist der sichere I/O-Pfad zwischen CPU und GPU. Bisher stellten die PCIe- und CXL-Verbindungen selbst mit Confidential-Computing-Technologien wie SEV oder TDX Schwachstellen dar, durch die Daten abgefangen oder manipuliert werden konnten. Die Agentic AI Platform-Infrastruktur minimiert dieses Risiko durch eine Kombination neuer Hardware-Sicherheitsstandards. Das Security Protocol and Data Model (SPDM) etabliert Link-Level-Verschlüsselung und -Authentifizierung zum Schutz des Datenverkehrs über PCIe und CXL, während Trusted DMA I/O (TDIO) Verschlüsselung und Schlüsselisolation für alle DMA-Transaktionen erzwingt und so verhindert, dass Peripheriegeräte auf den Host-Speicher zugreifen. PCI-SIG TDISP bietet eine hardwaregestützte Geräte-Attestierung für PCIe/CXL und stellt sicher, dass nur verifizierte GPUs, Netzwerkkarten oder Beschleuniger verschlüsselte Daten mit dem Host austauschen können. Das GPU-Quote wird von der GPU-Firmware generiert und vom CVM an den Attestierungsdienst weitergeleitet. Zusammen schließen diese Technologien die seit langem bestehende Lücke zwischen den Vertrauensgrenzen von CPU und GPU und bieten einen vollständig sicheren, zertifizierten Datenpfad über den gesamten Rechenstapel hinweg.

3.3. Vertrauliche Container und Schlüsselverwaltung für Anwendungen

Über der Hardware-Vertrauensbasis – verankert in CPU-basierten Technologien wie Intel TDX oder AMD SEV-SNP – arbeitet die Confidential VM Guest (CVM), die eine sichere Ausführungsumgebung für vertrauliche Workloads bereitstellt. Diese Schicht gewährleistet, dass die verwendeten Daten verschlüsselt und vom Host-Betriebssystem, Hypervisor und Cloud-Management-Stack isoliert bleiben, wodurch die Vertraulichkeit und Integrität aller Berechnungen gewahrt wird.

Die vertrauliche VM-Hostumgebung führt Kata-basierte vertrauliche Container aus, die in Red Hat OpenShift Sandbox enthalten sind. Diese kombinieren die flexible und ressourcenschonende Architektur von Containern mit der hohen Isolation hardwarebasierter virtueller Maschinen. Jede Containerinstanz läuft in ihrer eigenen CVM und profitiert von den Schutzmechanismen der Hardware, während gleichzeitig die Kompatibilität mit bestehenden Container-Orchestrierungsframeworks wie Kubernetes erhalten bleibt. Attestierungsmechanismen gewährleisten die Integrität und Vertrauenswürdigkeit der Umgebung, bevor sensible Workloads oder kryptografische Schlüssel bereitgestellt werden.

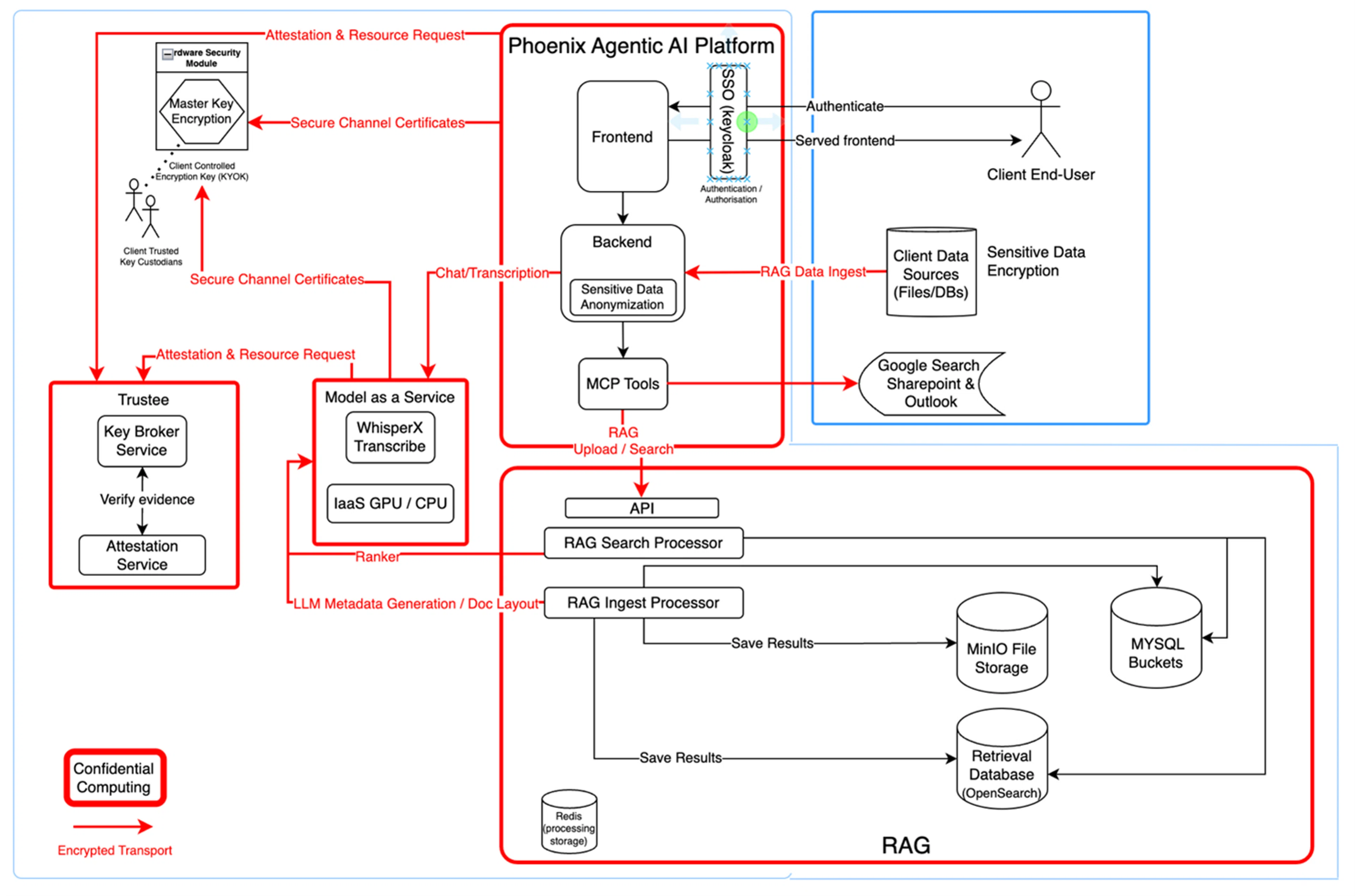

4. Agentic AI Platform Confidential Computing

Die Agentic AI-Plattform verwaltet Authentifizierung, Autorisierung und Datenzugriff über eine föderierte Single Sign-On (SSO)-Architektur auf Basis von Keycloak (siehe Abbildung 3). In einer typischen Bereitstellung kann Keycloak beispielsweise über eine OpenID Connect (OIDC)-Vertrauensstellung mit der Microsoft Entra ID eines Clients verbunden werden. In dieser Konfiguration fungiert die Entra ID als Identitätsanbieter und Keycloak als vertrauende Partei. So können sich Benutzer mit ihren Unternehmensanmeldeinformationen authentifizieren, während der Client die volle Kontrolle über Zugriffs- und MFA-Richtlinien behält. Keycloak validiert die von Entra ausgestellten Token und erstellt eigene Sitzungen und Zugriffstoken für nachgelagerte Dienste. Dadurch wird eine sichere, standardbasierte Authentifizierung gewährleistet, ohne dass Benutzerpasswörter verarbeitet werden müssen.

Abbildung 3: Vertrauliche Rechenarchitektur der Agentic AI Platform

Die Agentic AI-Plattform stellt benutzerfreundliche APIs für die abrufbasierte Textgenerierung (RAG), Transkription und Chat bereit und erzwingt dabei TLS-Verbindungen für die gesamte Kommunikation. Clientseitig kontrollierte Verschlüsselungsschlüssel und Hardware-Sicherheitsmodule (HSMs) schützen die Hauptschlüssel gemäß dem „Keep Your Own Key“-Modell (KYOK). Dadurch wird sichergestellt, dass die Kunden – und nicht der Plattformanbieter – die volle Kontrolle über ihre Daten und kryptografischen Materialien behalten. Middleware-Komponenten, sogenannte Model Context Protocol (MCP)-Tools, ermöglichen den sicheren Datenaustausch mit externen Clientsystemen wie SharePoint und Outlook und gewährleisten dabei den verschlüsselten Zustand sensibler Informationen während ihres gesamten Lebenszyklus.

Das Model-as-a-Service (MaaS)-Subsystem ermöglicht die vertrauliche Ausführung von KI-Modellen, beispielsweise Transkription mit WhisperX oder Inferenz großer Sprachmodelle (LLM). Diese Workloads werden in Kata-basierten vertraulichen Containern ausgeführt, wobei Hardware-Attestierung die Integrität vor der Bereitstellung verifiziert. GPU- und CPU-Rechenressourcen werden in vertraulichen Enklaven bereitgestellt, um die Vertraulichkeit von Modelleingaben, -ausgaben und Zwischenzuständen zu gewährleisten. Die Kommunikation zwischen dieser Serviceschicht und der übergeordneten Plattform erfolgt über verschlüsselte, TLS-gesicherte Transportkanäle. Dadurch werden die Vertraulichkeitsgarantien auch bei hochperformanter, verteilter KI-Verarbeitung erweitert.

Das Herzstück des Data-Intelligence-Workflows bildet das RAG-Subsystem (Retrieval-Augmented Generation). Diese Schicht erfasst, verarbeitet, indiziert und ruft Kundendaten für KI-gestützte Such- und Schlussfolgerungsprozesse ab. Der RAG-Ingest-Prozessor empfängt Daten sicher von Kundenquellen wie Dateien, Datenbanken oder Kommunikationssystemen, verarbeitet und speichert sie anschließend in verschlüsselten MinIO-Objektspeichern sowie MySQL- und OpenSearch-Abfragedatenbanken. Der RAG-Suchprozessor führt semantische Abfragen und Rankings durch und nutzt dabei Metadaten und Einbettungen, die von vertraulichen LLMs generiert werden. Alle Zwischenergebnisse werden in einem verschlüsselten Redis-Speicher zwischengespeichert, um sicherzustellen, dass keine Klartextdaten jemals außerhalb der vertrauenswürdigen Enklave-Umgebung offengelegt werden. Die API-Schicht verbindet dieses Subsystem mit der Agentic AI Platform und ermöglicht so nahtlose RAG-Upload- und Abfragevorgänge unter strenger Vertraulichkeit.

Auf Clientseite arbeiten Endbenutzer und Datenquellen innerhalb einer verschlüsselten Umgebung. Clientdaten bleiben sowohl bei der Speicherung als auch bei der Übertragung in die Sovereign Infrastructure verschlüsselt und sind durch clientseitige Schlüssel geschützt. Daten aus SharePoint, Outlook oder anderen Repositories fließen über die MCP-Konnektoren, wo sie sicher verarbeitet und für den Abruf indiziert werden, wobei die Verschlüsselung während des gesamten Übertragungs- und Übertragungsprozesses erhalten bleibt.

Innerhalb der Agentic AI Platform-Umgebung werden alle Benutzer- und Kundendaten vor jeder externen Interaktion streng vertraulich behandelt. Eine vertrauliche Schwärzungspipeline, die vollständig innerhalb der Backend-Umgebung (TEE) läuft, erkennt und entfernt personenbezogene Daten (PII), interne Kennungen, kryptografische Materialien und proprietäre Begriffe mithilfe von Open-Source-Frameworks, die um benutzerdefinierte Erkennungsmechanismen für domänenspezifische Muster erweitert wurden. Nach der Bereinigung erfolgt jede erforderliche externe Suche über einen MCP Google Search Connector, der innerhalb derselben vertraulichen Infrastruktur betrieben wird. Dieser Connector kommuniziert direkt mit der programmierbaren Such-API von Google über verschlüsselte TLS-Kanäle und verwendet dabei plattformkontrollierte Anmeldeinformationen, die unter der Kontrolle des Clientschlüssels stehen. Keine Klartext-Benutzerdaten, Kennungen oder Kontextmetadaten verlassen jemals die Enklave; alle ausgehenden Anfragen werden vor dem Verlassen abstrahiert, anonymisiert und richtlinienverifiziert, und die Suchergebnisse werden bei der Rückkehr zur Verarbeitung innerhalb der Enklave erneut verschlüsselt. Diese Architektur ermöglicht den sicheren Zugriff auf öffentliches Webwissen unter Wahrung der vollständigen Vertraulichkeit und Souveränität der Daten.

5. Schlussfolgerung

Die Agentic AI-Plattform demonstriert, wie vertrauliches Computing KI in einen wirklich souveränen Dienst verwandeln kann. Vom Silizium-Root of Trust bis hin zu verifizierten Anwendungsschichten ist jede Komponente des Stacks in eine durchgängige Kette von Verifizierung und Verschlüsselung eingebunden. CPU- und GPU-TEEs erzwingen die Isolation auf Hardwareebene; verschlüsselte I/O-Kanäle eliminieren herkömmliche Sicherheitslücken zwischen Geräten; und vertrauliche Container garantieren, dass KI-Workloads ausschließlich in verifizierten, richtlinienkonformen Umgebungen ausgeführt werden.

Durch föderierte Identität, hardwarebasierte Attestierung und clientseitig gesteuertes Schlüsselmanagement bietet das System mathematisch beweisbare Gewissheit, dass weder Bediener noch Dritte auf Kundendaten oder -modelle zugreifen können. In Kombination mit abrufgestützter Generierung, vertraulicher Modellausführung und datenintegrierter Governance innerhalb der Enklave liefert die Agentic AI Platform eine durchgängige Architektur für sichere, private und konforme KI-Operationen.